Ảnh khỏa thân giả AI tràn lan, đang hủy hoại cuộc sống của giới trẻ

- Bình Minh

- •

Ngôi sao YouTube Gabi Belle rùng mình khi nghe được rằng ảnh khỏa thân của cô đang được lan truyền trên mạng Internet. Cô chưa bao giờ chụp bức ảnh khỏa thân đứng trên cánh đồng, vậy nên cô biết bức ảnh đó chắc chắn là giả.

Belle, 26 tuổi, đã nhắn tin cho một đồng nghiệp và yêu cầu trợ giúp xóa hình ảnh. Các đồng nghiệp nói với cô rằng gần 100 bức ảnh giả của cô nằm rải rác trên Internet, hầu hết trên các trang web được biết đến là nơi lưu trữ nội dung khiêu dâm do trí tuệ nhân tạo (AI) tạo ra.

Belle cho biết, những bức ảnh này đã bị gỡ xuống vào tháng 7, nhưng những bức ảnh mới chụp cô trong cảnh ân ái lại xuất hiện.

Trong một cuộc phỏng vấn, Bell nói cô cảm thấy ghê tởm và bị xâm phạm. Những phần riêng tư đó không nên được hiển thị cho cả thế giới. Vì cô không đồng ý, nên việc ai đó giả mạo một bức ảnh của cô là điều thực sự kỳ lạ.

Năm nay, AI đang thúc đẩy sự bùng nổ chưa từng có về hình ảnh và video khiêu dâm giả mạo.

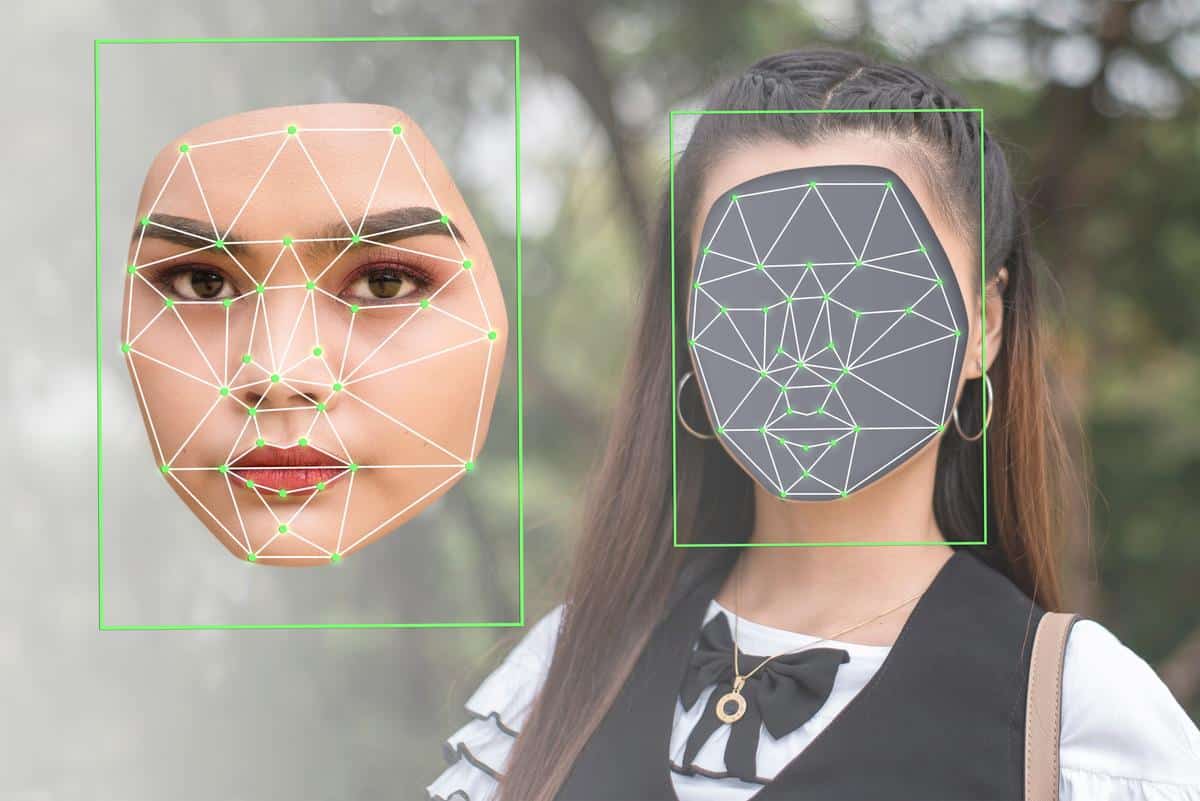

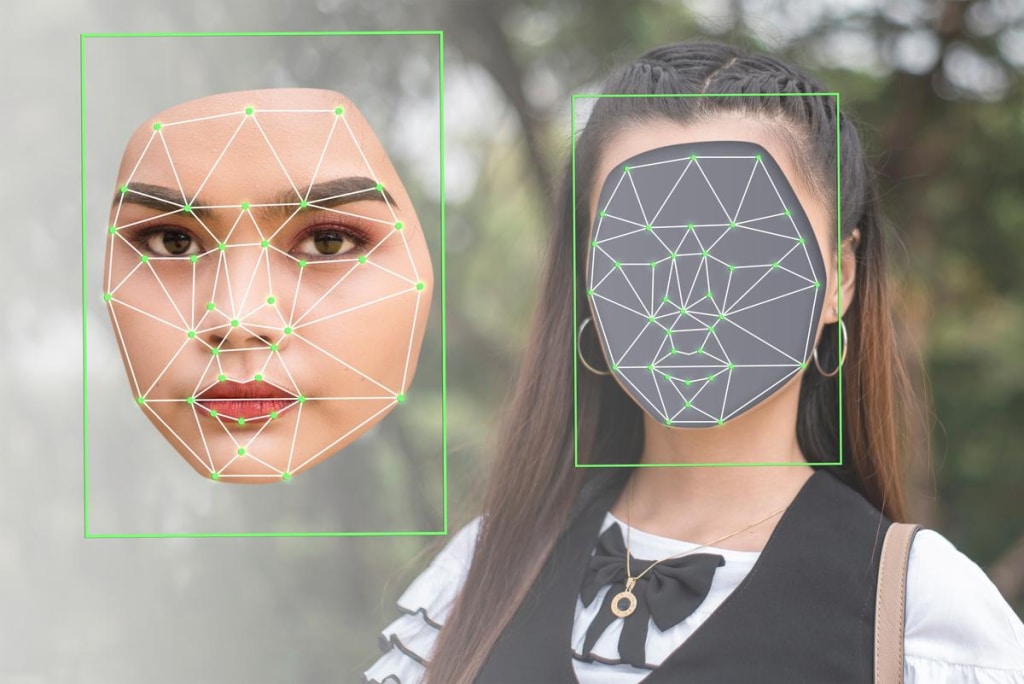

Điều này được hỗ trợ bởi sự phát triển của các công cụ AI rẻ tiền và dễ sử dụng. Chúng có thể “cởi đồ” của người trong ảnh, phân tích cơ thể trần truồng của họ trông như thế nào, và hiển thị chúng trong ảnh, hoặc thay thế khuôn mặt người vào video khiêu dâm.

Theo nhà phân tích ngành Genevieve Oh, số lượng ảnh khỏa thân giả trên 10 trang web hàng đầu lưu trữ ảnh khiêu dâm do AI tạo ra, đã tăng hơn 290% kể từ năm 2018.

Các trang web này nhắm mục tiêu vào những người nổi tiếng và nhân vật chính trị. Những kẻ xấu sử dụng chân dung của họ để hạ nhục mục tiêu, tống tiền hoặc thực hiện những ảo tưởng riêng tư.

Các nạn nhân không có quyền truy đòi. Hiện tại không có luật liên bang nào quy định về nội dung khiêu dâm deepfake – những video giả mạo có sức thuyết phục cao được thực hiện bằng AI, chỉ một số ít bang ban hành quy định liên quan.

Ngày 30/10, Tổng thống Biden đã ban hành đề xuất mệnh lệnh hành pháp về AI, nhưng không yêu cầu các công ty phải dán nhãn ảnh, video và âm thanh do trí tuệ nhân tạo tạo ra, để chỉ ra rằng chúng là tác phẩm của AI.

Trong khi đó, các học giả pháp lý đã cảnh báo rằng những hình ảnh do AI tạo ra có thể không được bảo vệ bản quyền đối với các bức chân dung cá nhân, vì chúng được vẽ từ bộ sưu tập hàng triệu hình ảnh.

Tiffany Li, giáo sư luật tại Đại học San Francisco, cho biết đây rõ ràng là một vấn đề rất nghiêm trọng.

Sự xuất hiện của các hình ảnh được hỗ trợ bởi AI đặt ra những rủi ro đặc biệt cho phụ nữ và thanh thiếu niên, nhiều người trong số họ chưa sẵn sàng cho tình huống này.

Một nghiên cứu năm 2019 của Sensity AI, công ty chuyên theo dõi các tác phẩm deepfake, cho thấy 96% hình ảnh deepfake là khiêu dâm và 99% ảnh là phụ nữ.

Sophie Maddocks, nhà nghiên cứu tại Đại học Pennsylvania và là người ủng hộ quyền kỹ thuật số, cho biết hiện tại, họ chủ yếu nhắm vào các cô gái trẻ và phụ nữ không lọt vào mắt công chúng.

Một cô gái 14 tuổi cũng phát hiện ra bức ảnh khỏa thân của mình trên mạng. Cô chưa bao giờ chụp ảnh khỏa thân.

Theo cảnh sát, một nhóm chàng trai địa phương đã lấy những bức ảnh mặc quần áo từ hồ sơ mạng xã hội của một số cô gái trong thị trấn của họ, sau đó sử dụng ứng dụng “khỏa thân” trí tuệ nhân tạo, để tạo ra những bức ảnh khỏa thân.

Cô Genevieve Oh đã kiểm tra 10 trang web hình ảnh khiêu dâm giả mạo hàng đầu, và phát hiện ra rằng hơn 415.000 hình ảnh khiêu dâm giả đã được tải lên trong năm nay, với gần 90 triệu lượt xem.

Các video khiêu dâm do AI tạo ra cũng đang bùng nổ trên mạng.

Sau khi tìm kiếm 40 trang web video giả phổ biến nhất, cô nhận thấy có hơn 143.000 video mới vào năm 2023, vượt quá tất cả video mới từ năm 2016 – 2022. Cô phát hiện ra các video giả mạo đã được xem hơn 4,2 tỷ lần.

Vào tháng 6, FBI đã cảnh báo về sự gia tăng hoạt động tống tiền của những kẻ lừa đảo, yêu cầu thanh toán hoặc chụp ảnh, để đổi lấy việc không phát tán hình ảnh khiêu dâm. Mặc dù không rõ có bao nhiêu hình ảnh trong số này được tạo ra bởi AI, nhưng hoạt động này đang ngày càng mở rộng.

FBI nói với Washington Post rằng tính đến tháng 9, hơn 26.800 người đã trở thành nạn nhân của hoạt động “tống tiền”, tăng 149% so với năm 2019.

Google có các chính sách nhằm ngăn chặn hình ảnh khiêu dâm không được chủ nhân bức ảnh đồng ý hiển thị trong kết quả tìm kiếm. Nhưng các biện pháp bảo vệ chống lại hành vi giả mạo kém hiệu quả hơn.

Ngay cả khi không tìm kiếm cụ thể nội dung do AI tạo ra, các hình ảnh khiêu dâm deepfake và các công cụ sản xuất vẫn xuất hiện nổi bật trong các công cụ tìm kiếm của Google.

Cô Genevieve Oh đã ghi lại hơn 10 ví dụ trong ảnh chụp màn hình, tất cả đều được Washington Post xác nhận độc lập.

Trong trường hợp không có luật liên bang, ít nhất 9 tiểu bang, gồm California, Texas và Virginia, đã thông qua các dự luật nhắm mục tiêu vào deepfake. Nhưng phạm vi của các luật này khác nhau.

Ở một số bang, nạn nhân có thể nộp đơn tố cáo hình sự, trong khi những bang khác chỉ cho phép khởi kiện dân sự, mặc dù rất khó để xác định sẽ kiện ai.

Sam Gregory, Giám đốc điều hành của nhóm công nghệ vận động nhân quyền Witness, cho biết nỗ lực quản lý các hình ảnh và video do AI tạo ra thường là để ngăn chặn sự phổ biến trên quy mô lớn, như giải quyết những lo ngại về can thiệp bầu cử.

Ông cũng nói thêm rằng những quy tắc này sẽ ít ảnh hưởng đến nội dung khiêu dâm deepfake, dù hình ảnh được chia sẻ ở quy mô nhỏ có thể tàn phá cuộc sống của một con người.

Một người đàn ông Hàn Quốc đã bị kết án tù vì sử dụng AI để tạo ra những hình ảnh khiêu dâm trẻ em. Theo Tòa án quận Busan và Văn phòng công tố quận, người đàn ông giấu tên, ở độ tuổi 40, đã bị kết án 2 năm rưỡi tù giam trong tháng 9.

Văn phòng công tố nói với CNN rằng vào tháng 4, nhờ AI, ông ta đã tạo ra khoảng 360 hình ảnh. Những hình ảnh này không được phát tán và đã bị cảnh sát tịch thu.

Đầu tháng 9, cảnh sát Tây Ban Nha đã mở một cuộc điều tra sau khi hình ảnh các cô gái chưa đủ tuổi vị thành niên được thay đổi bằng AI để cởi bỏ quần áo, và gửi đi khắp thị trấn. Một cậu bé đã cố gắng tống tiền một trong các cô gái bằng cách sử dụng hình ảnh khỏa thân của cô gái này, mẹ của cô gái nói với kênh truyền hình Canal Extremadura.

Trong nhiều năm, deepfake đã được sử dụng để đưa khuôn mặt của phụ nữ vào các video khiêu dâm mà không có sự đồng ý của họ. Các video thường xuất hiện chân thực đến mức nạn nhân nữ khó có thể phủ nhận đó không thực sự là họ. Bất kỳ ai cũng có nguy cơ trở thành nạn nhân của hiểm họa ảnh khiêu dâm do AI tạo ra.

Từ khóa trí tuệ nhân tạo AI deepfake ảnh khỏa thân lừa đảo bằng deepfake