5 năm nữa có thể có AI giống con người – Dự đoán của CEO Nvidia

- Dương Thiên Tư

- •

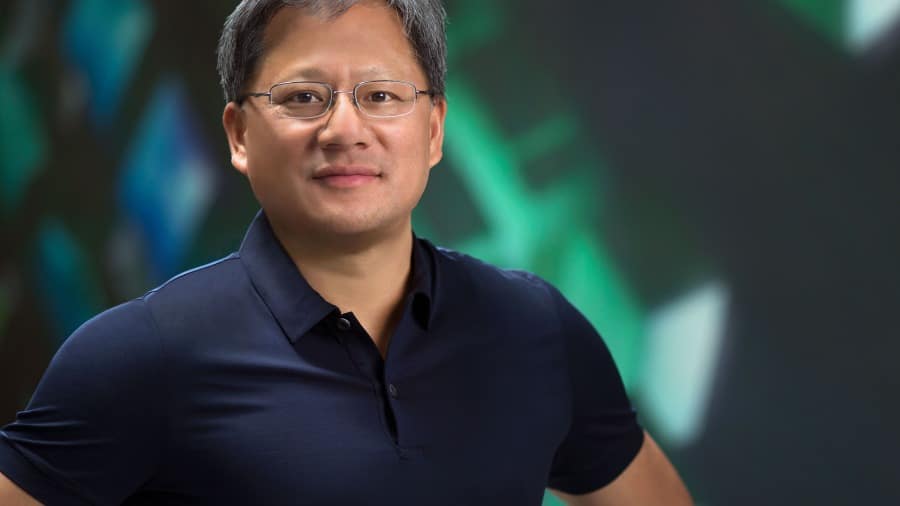

OpenAI đang nỗ lực cho mục tiêu cuối cùng của công ty là tạo ra trí tuệ nhân tạo (AI) tổng hợp (Artificial general intelligence, AGI). CEO của ‘gã khổng lồ’ chip Nvidia đồng thời là người thúc đẩy AI, ông Jensen Huang (Hoàng Nhân Huân), đã chỉ ra trong Hội nghị thượng đỉnh chính sách kinh tế của Viện Stanford ở California vào ngày 1/3 rằng có thể trong 5 năm nữa sẽ xuất hiện AGI.

AGI giống con người dự kiến sẽ xuất hiện trong vòng 5 năm tới

AGI là một hệ thống thông minh có thể vượt qua con người trong nhiều lĩnh vực khác nhau. Công ty OpenAI cho rằng AGI có tiềm năng thay đổi xã hội và mang lại lợi ích to lớn, nhưng cũng có thể mang đến những rủi ro nghiêm trọng.

Hôm 1/3, ông Jensen Huang tuyên bố tại Hội nghị thượng đỉnh chính sách kinh tế của Viện Stanford ở California rằng dự kiến trong 5 năm tới sẽ ra mắt AGI – còn gọi là AI mạnh (Strong AI). Về lý thuyết, AGI có thể học hỏi và suy luận như con người, đồng thời có khả năng giải quyết các vấn đề phức tạp và đưa ra quyết định một cách độc lập.

Ông cho hay đáp án nằm ở việc mục tiêu này được định nghĩa như thế nào, nếu định nghĩa là có thể vượt qua thử nghiệm trên người thì AGI sẽ sớm xuất hiện: “Nếu bạn lập một danh sách bài kiểm tra và đưa nó ra trước cộng đồng khoa học máy tính, tôi đoán rằng trong khoảng 5 năm nữa chúng ta sẽ có thể gặt hái kết quả tốt trong mọi bài kiểm tra.”

AI hiện có thể vượt qua các bài kiểm tra như kỳ thi luật, nhưng vẫn gặp khó khăn khi đối mặt với các bài kiểm tra y tế chuyên nghiệp. Nhưng ông Jensen Huang tin rằng trong 5 năm nữa AI sẽ có thể vượt qua mọi bài kiểm tra.

Ông Huang cũng trả lời một câu hỏi khác tại hội nghị thượng đỉnh, đó là cần bao nhiêu xưởng đúc chip để hỗ trợ việc mở rộng ngành công nghiệp AI. Một số phương tiện truyền thông đưa tin, CEO OpenAI Sam Altman cho rằng cần có nhiều nhà máy hơn, nhưng ông nghĩ điều đó là “không cần thiết”. Ông Huang lưu ý mặc dù hiện tại có nhu cầu về nhiều chip hơn, nhưng hiệu suất của chip sẽ được cải thiện theo thời gian, điều này sẽ hạn chế số lượng chip cần thiết.

“Chúng ta sẽ cần nhiều nhà máy hơn. Nhưng lưu ý rằng theo thời gian chúng ta cũng đang cải thiện đáng kể các thuật toán và xử lý (AI)”, ông Huang nói. “Hiệu quả tính toán sẽ không giữ nguyên ở mức như ngày nay. Trong 10 năm nữa, tôi sẽ tăng sức mạnh tính toán lên hàng triệu lần”.

Khác biệt giữa AGI và AI là gì?

Qua các nguồn tin đến nay chúng ta biết được cho thấy, AI đề cập đến một hệ thống thông minh có thể thực hiện các nhiệm vụ cụ thể hoặc giải quyết các vấn đề cụ thể, trong khi AGI đề cập đến một hệ thống thông minh có thể đạt hoặc vượt trình độ của con người trong bất kỳ nhiệm vụ hoặc vấn đề nào. AGI có các khả năng khác như học tập, lý luận, sáng tạo… như người thật.

Hiện vẫn còn nhiều tranh cãi về định nghĩa AI, các nhà khoa học ở các lĩnh vực khác nhau có những định nghĩa và tiêu chuẩn khác nhau. Khái niệm AI thông thường liên quan đến “AI yếu” mà hiện đang triển khai rộng rãi, sau này có những nét mới đề cập đến AI giỏi thực hiện một nhiệm vụ nào đó và giải quyết các vấn đề cụ thể, nhưng không có ý thức tự chủ. Các ứng dụng bao gồm dịch vụ khách hàng thông minh, lái xe không người lái, đề xuất thuật toán…

Đạt được AGI là một trong những mục tiêu lâu dài của Thung lũng Silicon. Công ty OpenAI cho rằng AGI có thể đạt được và có thể ra mắt trong tương lai gần. Do đó, OpenAI đang tích cực khám phá cách xây dựng AGI và đã đạt được một số tiến bộ quan trọng.

Tuy nhiên, sự phát triển của AGI cũng gặp nhiều rủi ro và lo ngại.

Trước hết, AGI có thể gây ra những tác động và thay đổi rất lớn đến xã hội loài người, như thay đổi cơ cấu việc làm, phân bổ kinh tế, hệ thống pháp luật, đạo đức… Những thay đổi này có thể có tác động tích cực hoặc tiêu cực và cũng có thể gây ra bất ổn và xung đột xã hội.

Thứ hai, AGI có thể gây ra các mối đe dọa đối với an ninh loài người như bị sử dụng với mục đích xấu, gây tai nạn, mất kiểm soát hoặc nổi loạn… Những mối đe dọa này có thể gây nguy hiểm cho tôn nghiêm và sinh tồn của loài người, hoặc thậm chí dẫn đến hủy diệt loài người.

Nhiều nguồn tin chỉ ra, OpenAI đang đàm phán một vòng tài trợ mới với nhiều nhà đầu tư, mức định giá có thể lên tới 100 tỷ USD trở lên. Khoản đầu tư của Microsoft không chỉ cung cấp vốn cho OpenAI, mà còn cung cấp nền tảng phần cứng và phần mềm để phát triển và triển khai AGI trên nền tảng đám mây Azure của Microsoft.

Musk kiện OpenAI và CEO Altman vi phạm mục đích ban đầu

Việc phát triển không giới hạn của AI đã đe dọa an ninh loài người, điều này không còn ở tương lai nữa mà thực sự đang tồn tại. Vào 29/2, CEO Tesla là ông Elon Musk đã đệ đơn kiện lên Tòa án cấp cao San Francisco (do công ty luật Irell & Manella ở Los Angeles đại diện), kiện OpenAI và CEO Sam Altman.

Ông Musk cho biết trong đơn kiện rằng ông Altman và OpenAI đã vi phạm thỏa thuận khi thành lập công ty nghiên cứu AI này, mục tiêu hướng tới ban đầu để phát triển công nghệ mang lại lợi ích cho nhân loại hơn là lợi nhuận.

Ông Musk tuyên bố rằng mối quan hệ gần đây của OpenAI với ‘gã khổng lồ’ công nghệ Microsoft đã vi phạm ý định ban đầu của công ty là phát triển AI thông dụng nguồn mở.

Hồ sơ tòa án cho thấy ông Musk đã đệ đơn tố cáo OpenAI bao gồm vi phạm hợp đồng, vi phạm nghĩa vụ ủy thác và các hoạt động kinh doanh không công bằng, đồng thời yêu cầu công ty quay trở lại nguồn mở. Ông Musk cũng yêu cầu tòa án ban hành lệnh cấm OpenAI và chủ tịch Gregory của công ty này. Ông nói rằng Brockman và Sam Altman (đồng bị cáo trong vụ kiện) và Microsoft được hưởng lợi từ công nghệ AI của công ty.

Musk cho biết: “OpenAI đã chuyển đổi thành một công ty con nguồn đóng trên thực tế của Microsoft, công ty công nghệ lớn nhất thế giới. Dưới lãnh đạo của ban giám đốc mới, họ không chỉ phát triển mà còn thúc đẩy AGI để tối ưu hóa lợi nhuận của Microsoft chứ không vì phúc lợi của nhân loại”.

BREAKING: Elon Musk has filed a lawsuit against Open AI and Sam Altman for breach of contract.

The lawsuit accuses Altman et al with having betrayed an agreement from Open AI's founding to remain as a non-profit company. pic.twitter.com/GPv8NFvsnt

— X News Daily (@xDaily) March 1, 2024

Ông Musk cho biết AGI là một loại AI được phát triển để tự động thể hiện mức độ nhận thức tương đương với con người, điều này được phản ánh trong mô hình GPT-4 của OpenAI. Ông cho rằng GPT-4 ra mắt vào tháng 3/2023 là mô hình đóng so với các phiên bản trước đó – động thái này được thúc đẩy bởi những cân nhắc kinh doanh hơn là lợi ích con người.

Ông viết trong đơn kiện: “Các chi tiết nội bộ của GPT-4 chỉ được OpenAI và Microsoft biết dựa trên thông tin và niềm tin. Do đó GPT-4 là đối lập của ‘AI mở’ và việc này có lý do thương mại: Microsoft muốn kiếm tiền bằng cách bán GPT-4 cho công chúng, điều này sẽ không thể thực hiện được nếu OpenAI (được đề nghị phải làm như vậy) cung cấp công nghệ này miễn phí cho công chúng… Như vậy là không được phép… và trái với Thỏa thuận sáng lập, các bị cáo đã chọn sử dụng GPT-4 không phải vì lợi ích của nhân loại mà như một công nghệ được cấp bằng sáng chế nhằm tối đa hóa lợi nhuận cho công ty lớn nhất thế giới [Microsoft]”.

Trong đơn kiện, ông Musk cũng đề cập đến vụ “đảo chính” OpenAI năm 2023. Ông cho biết sự ra đi ngắn ngủi của ông Altman đã khiến Microsoft phải vào cuộc và buộc các thành viên hội đồng, những người đang cố gắng loại bỏ ông Altman, phải từ chức. Các thành viên hội đồng hiện tại của OpenAI không còn là những nhà khoa học và nhà nghiên cứu thúc đẩy công nghệ vì phúc lợi của loài người.

Ông Elon Musk là người đồng sáng lập OpenAI nhưng đã rời khỏi hội đồng quản trị vào năm 2018. Ông cho biết xung đột giữa hội đồng quản trị và ông Altman bắt nguồn từ sự phát triển của GPT-4 và thế hệ tiếp theo là phát triển hình thành AGI, điều mà ông lo ngại có thể gây nguy hiểm cho nhân loại.

Lo ngại AI có thể hủy diệt loài người

Tháng 11 năm ngoái, cuộc cải tổ nhân sự của OpenAI đã trở thành tin tức lớn trong giới công nghệ. Thông tin cha đẻ của ChatGPT là Sam Altman bị loại khỏi ban giám đốc vào ngày 17/11 đã gây chấn động thế giới và làm dấy lên những đồn đoán không ngừng. Có thông tin cho rằng Altman có thể đã quá cấp tiến khi tiến hành nghiên cứu AI, điều này có thể dẫn tới AI “một ngày nào đó sẽ hủy diệt loài người”.

Theo những phân tích của giới quan sát vào thời điểm đó, việc ông Altman đột ngột bị loại bỏ đã đặt vấn đề về một cuộc tranh luận sẽ nảy sinh – mâu thuẫn giữa sự phát triển của AI và sự an toàn của nhân loại – giống như những tranh luận về chỉnh sửa gen, sự phát triển của AI cũng đặt ra ranh giới về mặt đạo đức.

Kể từ năm trước, ChatGPT do OpenAI xây dựng đã gây ra một cuộc cách mạng trong ngành công nghệ và thúc đẩy sự phát triển nhanh chóng của AI sáng tạo. Đến nay tất cả AI sáng tạo, bao gồm cả phần mềm AI được Microsoft sử dụng, đều được xây dựng trên ChatGPT.

ChatGPT được phát hành vào tháng 11/2022. Chỉ trong một năm, số lượng người dùng toàn cầu đã vượt quá 100 triệu và 2 triệu người đang tham gia phát triển.

Một số người lưu ý vấn đề an ninh cho rằng OpenAI và các công ty khác đang phát triển AI quá nhanh và phớt lờ những cảnh báo thận trọng. Cuộc tranh cãi này đã diễn ra giữa các nhân viên OpenAI, năm 2020 một nhóm nhân viên OpenAI đã từ chức vì lo ngại công ty quá thương mại và đặt lợi ích lên trên vấn đề an toàn. Một số nhân viên sau đó đã thành lập Anthropic, họ cho rằng ông Altman có thể quá cấp tiến [gây liều lĩnh] trong việc theo đuổi nghiên cứu AI.

OpenAI được thành lập vào năm 2015 với tư cách là tổ chức nghiên cứu phi lợi nhuận, phải đến năm 2019 mới thành lập công ty con có lợi nhuận hạn chế. OpenAI tuyên bố đây là một thỏa thuận sáng tạo, lợi nhuận cho nhà đầu tư bị hạn chế, động thái này nhằm giúp công ty duy trì sứ mệnh phi lợi nhuận. Công ty trao cho ban giám đốc quyền quản lý một thực thể có lợi nhuận hạn chế. Điều này khác với các công ty vì lợi nhuận thông thường khác, ông Altman với tư cách là người lãnh đạo công ty không trực tiếp nắm giữ bất kỳ cổ phần nào trong OpenAI và hội đồng quản trị có quyền biểu quyết trực tiếp trục xuất ông.

Ít nhất hai trong số các thành viên hội đồng quản trị, là Tasha McCauley và Helen Toner có quan hệ với phong trào Lòng vị tha hiệu quả (Effective Altruism) – một phong trào đạo đức mà các thành viên hướng đến thúc đẩy phát triển AI một cách an toàn, họ cho rằng AI mạnh đến mức mất kiểm soát có ngày sẽ hủy diệt loài người.

Từ nhà vật lý lý thuyết nổi tiếng người Anh Stephen Hawking tới các chuyên gia về AI hàng đầu thế giới và CEO công nghệ Elon Musk đã bày tỏ mối đe dọa của AI đối với sự tồn tại của con người.

Nhà vật lý Stephen Hawking đã qua đời. Tháng 8/2015, ông Hawking lần đầu tiên cảnh cáo vấn đề nguy hiểm của AI trên trang web Reddit của Mỹ. Ông tin chắc rằng AI sẽ phát triển hướng đến khả năng có thể tự chủ, từ đó trong trường hợp loài người khác biệt với nó thì AI có thể gián tiếp hoặc trực tiếp hủy diệt loài người.

Sau đó ông Hawking tiếp tục cảnh báo: “Hệ thống AI sẽ tự thiết kế lại, tự hoàn thiện với tốc độ chưa từng có”; “Nghiên cứu AI giống như triệu hồi ma quỷ”; “Sự phát triển toàn diện của AI một ngày nào đó có thể dẫn tới sự diệt vong của loài người!”…

Dương Thiên Tư, Vision Times

Từ khóa AGI trí tuệ nhân tạo Elon Musk AI openAI Sam Altman